Da transparência à gestão de risco, o que precisam de fazer as empresas com nova lei da IA?

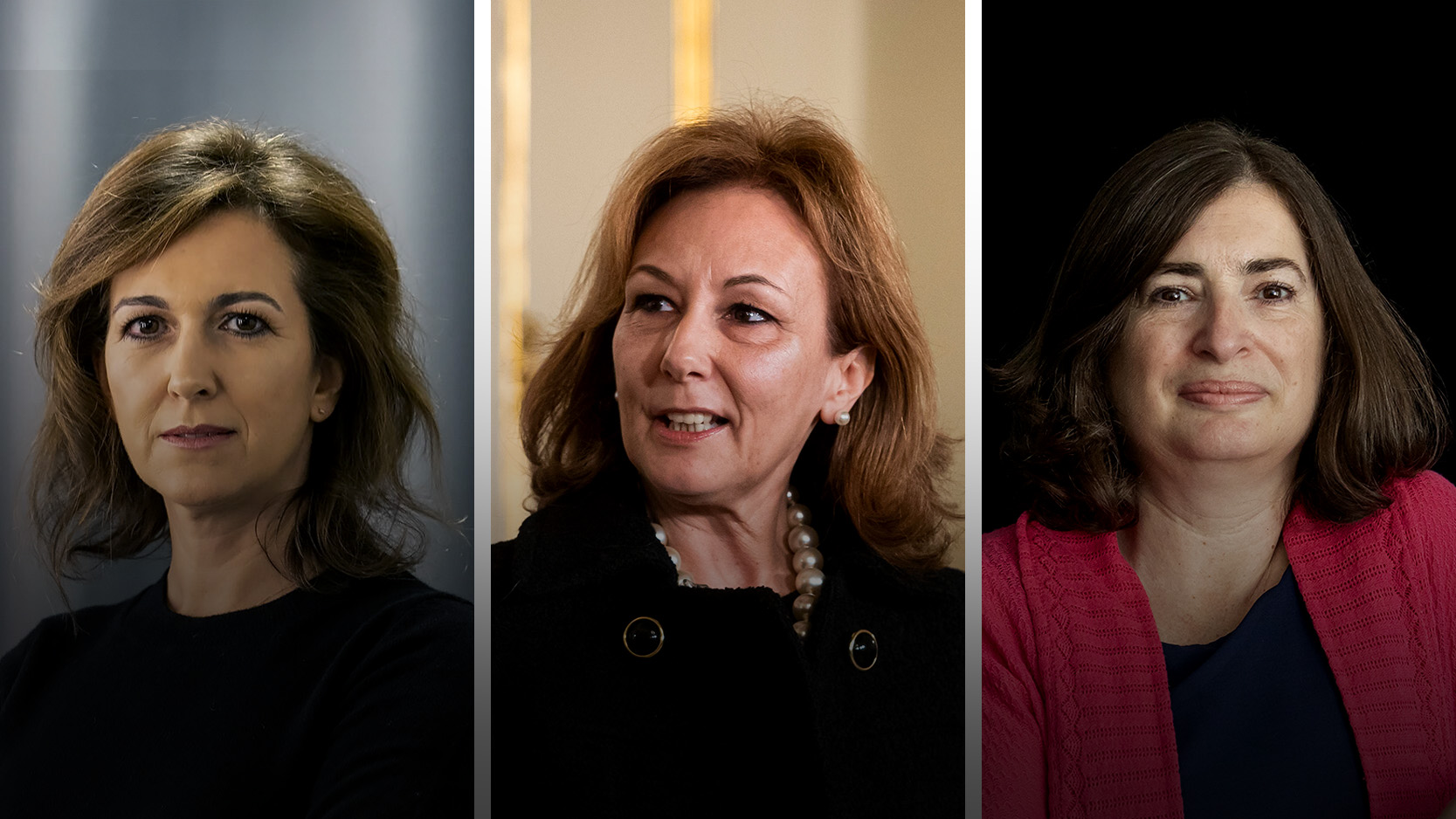

"Inteligência Artificial: a lei que vem regular o futuro" foi o tema em destaque num painel moderado pelo sócio da PLMJ, Pedro Lomba. Descubra as algumas das recomendações sugeridas às empresas.

Transparência, “start small” e gestão de riscos são algumas das recomendações de proteção para as organizações e empresas face à chegada do Regulamento de Inteligência Artificial apontadas pelos especialistas na 7.ª edição da Advocatus Summit Lisboa.

“Um aspeto importante é a parte do data governance. Depois temos outra parte, que é a de gestão de riscos, que acho que o que é muito importante neste caso, dada a imprevisibilidade de alguns destes temas, é a necessidade de ter já um género de um manual em que vamos tentar prever quais são os riscos que existem e tentar desenhar metodologias para os mitigar. Depois temos também a parte de estabelecimento de um sistema de gestão de qualidade que nos vai ajudar a definir como é que o processo todo vai funcionar, as várias etapas, etc”, apontou Luís Guerra e Silva, professor do INESC-ID – Instituto Superior Técnico e orador no painel “Inteligência Artificial: a lei que vem regular o futuro”.

Já para Inês Dias Pinheiro, associada coordenadora da PLMJ, considera ser importante que as empresas façam uma escolha “estratégica” e “muito inteligente” sobre os use cases que vão implementar. Ou seja, aconselha as organizações a começar por projetos pequenos e com algo que permita testar não só os standards de governance, mas também o conforto das próprias equipas de compliance. Assim, conseguiriam aferir como estão a gerir o risco e com uma implementação mais fácil.

“Não vamos focar os nossos esforços na negociação dos contratos com fornecedores. Vamos selecionar bem os fornecedores. A fase da seleção é tão ou mais importante como a fase da contratação e aqui a confiança que os fornecedores oferecem é essencial. As empresas grandes já têm processos de onboarding de fornecedores que os avaliam nas suas diferentes perspetivas, seja de proteção de dados, cibersegurança, continuidade de negócio, e temos aqui mais um capítulo no qual eles devem ser avaliados e depois, se forem selecionados, passamos à negociação e essa fase será muito mais simples”, explicou a advogada.

A associada coordenadora da PLMJ apontou ainda uma terceira recomendação: tornar todos os indivíduos da empresa como gestores de risco e “educá-los cada um para as suas funções” e perceber que há uma responsabilidade na utilização destas ferramentas.

Por outro lado, Marta Salgado Areias, associada sénior da PLMJ, apontou que uma das coisas “mais difíceis” será a transparência ao longo de toda a cadeia, desde a entidade que produz o sistema e que está obrigada a dar as necessárias instruções a quem irá utilizar o sistema até a quem dará a informação ao utilizador final. “Acho que isto irá evitar vários dissabores”, assume.

“Diria que a monitorização constante da evolução da utilização da ferramenta será essencial e a documentação, ou seja, saber demonstrar”, referiu.

Sobre o papel exato das auditorias no regulamento de IA, Inês Dias Pinheiro, associada coordenadora da PLMJ, considera que é um papel que ainda vai ter de ser descoberto. “Falando da auditoria num sentido mais mais amplo, o próprio regulamento não tem muitas referências explícitas ao conceito de auditoria. Tem duas referências que nos remetem para dois mecanismos que podemos chamar de mecanismos de enforcement, a avaliação de conformidade e depois os planos de acompanhamento pós-comercialização. Temos aqui duas referências expressas no regulamento a mecanismos de auditoria e podemos tirar uma conclusão, para já preliminar, de que o Regulamento Inteligência Artificial dá-nos uma proposta daquilo que devem ser as auditorias a nível europeu para esta matéria“, explicou.

Inês Dias Pinheiro sublinhou ainda que já existem organizações e setores, como o dos bancos, que fazem auditorias a processos automatizados e a que já tem uma grande maturidade nisso, não sendo uma novidade. “O que é que pode ser uma novidade aqui é que as auditorias são intensas, prolongadas, exigem recursos e não sei até que ponto é que este modelo de auditoria se coaduna com o dinamismo da inteligência artificial”, acrescentou.

Relativamente aos auditores, a advogada acredita que o papel dos mesmo vai ser influenciado por três aspetos: o âmbito material da avaliação, as bases normativas que vão servir de referência para a auditoria e os papéis e as responsabilidades de cada ser no processo de auditoria.

Já Marta Salgado Areias, associada sénior da PLMJ, alertou que não há nenhuma especificidade no Regulamento no que diz respeito ao tratamento de dados pessoais. “Vamos ter que determinar se há dados de pessoas singulares e, portanto, vamos ter que voltar sempre ao RGPD e qualificar estas figuras do Regulamento de Inteligência Artificial, quer como responsável pelo tratamento, quer como subcontratante”, referiu.

A advogada exemplificou a coordenação entre estes dois diplomas com o caso hipotético de que a Netflix desenvolver um sistema de recomendações e para tal utiliza um conjunto de dados, ou seja, vai atuar na qualidade de responsável pelo tratamento. Logo, “quando houver dados de pessoas singulares vai ter que cumprir essas obrigações e depois também em coordenação com data governance e com o datec”. “Até porque sabemos que no âmbito da agenda digital há uma série de problemas que serão certamente uma dor de cabeça para coordenar”, disse.

Ou seja, à luz do regulamento, uma empresa pode ser um fornecedor – quem desenvolve o sistema ou faça uma alteração substancial -, ou um utilizador de um sistema de inteligência artificial e, caso seja uma destas figuras, pode ser conjuntamente responsável com o utilizador do ponto de vista do Regulamento Geral de Proteção de Dados.

Luís Guerra e Silva sublinhou também que a inteligência artificial generativa tem tido muito impacto na sociedade, dando como exemplo o ChatGPT, que é utilizado por milhares de pessoas. O professor do INESC-ID salientou ainda as alterações que foram feitas ao nível do regulamento, em particular na generativa. “Em termos de IA que nós utilizamos hoje em dia, embora a generativa tenha sido aquilo que tenha um maior impacto, nós já há muitos anos utilizamos muitos outros sistemas”, referiu, notando que existe uma enorme variedade de algoritmos de IA.

“Existe aqui uma grande diversidade de sistemas que vão ter que ser tratados. O passo inicial e principal na definição de risco é definir claramente qual é a aplicação e garantir que, dentro do possível, que o modelo depois não é utilizado de uma forma diferente daquela aplicação que se tem em vista e para a qual o risco vai ser calculado“, acrescentou.

Luís Guerra e Silva apontou o problema da caixa preta aos sistemas de IA. “Basicamente nós sabemos que o sistema está a dar um resultado que está correto e que nos interessa, mas não sabemos como é que durante a fase de treino o próprio sistema se organizou internamente para conseguir acumular aquele conhecimento e produzir aquele resultado. Portanto, é uma das características desse sistema, deste tipo de sistemas e que é difícil explicar o comportamento deles”, disse.

Assim, considera que os modelos, por serem imprevisíveis, vão necessitar de um ciclo de aperfeiçoamento em que “rapidamente” se deve conseguir detetar e registar os problemas e depois tomar medidas corretivas num ciclo muito curto.

Sobre o ciclo de desenvolvimento de uma tecnologia de IA, Marta Salgado Areias considera que aspetos como a legalidade do sistema devem ser ponderados. “Uma das grandes funções deste regulamento será determinar quais é que serão as linhas vermelhas e aquilo que não se pode desenvolver”, acrescentou. A advogada apontou ainda como necessário fazer avaliações de conformidade, uma vez que o core da regulamentação é relativamente a sistemas de alto risco, implementar o modelo de governance e continuar a monitorizar este sistema.

Luís Guerra e Silva assume como essencial a regulação, uma vez que as tecnologias de IA estão a tomar conta do dia-a-dia da sociedade. “A regulação é essencial para garantir que estas tecnologias são utilizadas de forma correta e realmente se traduzem num benefício para a sociedade e não num problema. Por exemplo, o ChatGPT muito brevemente prevejo que se possa tornar num o sistema operativo, porque na realidade vão ser aquela camada de software base com que vamos passar a interagir”, assume.

Para além de lidarem com a litigância, o professor do Técnico considera que o papel dos advogados vai passar por ajudar as organizações a adaptarem os seus processos e a a implementar processos de compliance.

Com confiança nos Data Protection Officer (DPO), Inês Dias Pinheiro acredita que estes encarregados estão “habituados” a analisar este tipo de modelos e bem preparados. “No fundo, o que vai fazer é continuar a fazer o que já faz, que é negociar com as áreas de negócio e aplicar os princípios e acho que estão bem preparados para isso”, assumiu. A advogada alertou ainda que é necessário é pensar na aplicabilidade das regras não só na fase de teste e de treino, mas depois também na fase da implementação.

Marta Salgado Areias recorda que é necessária ainda a coordenação com a legislação sobre o consumo, uma vez que “pega” em três vetores muito importantes na legislação de consumo: evitar manipulação, a assimetria informativa e o desequilíbrio entre profissional e consumidor. “São três temas muitíssimo relevantes e com os quais já temos vindo a ter algumas dificuldades de compliance. Ora, com a Inteligência artificial, estes temas assumem uma nova dimensão de complexidade. O legislador teve essa noção agora na proposta de diretiva da responsabilidade em matéria de inteligência artificial”, disse.

Assine o ECO Premium

No momento em que a informação é mais importante do que nunca, apoie o jornalismo independente e rigoroso.

De que forma? Assine o ECO Premium e tenha acesso a notícias exclusivas, à opinião que conta, às reportagens e especiais que mostram o outro lado da história.

Esta assinatura é uma forma de apoiar o ECO e os seus jornalistas. A nossa contrapartida é o jornalismo independente, rigoroso e credível.

Comentários ({{ total }})

Da transparência à gestão de risco, o que precisam de fazer as empresas com nova lei da IA?

{{ noCommentsLabel }}